首页 > 代码库 > LVS-NAT模式负载均衡的实现

LVS-NAT模式负载均衡的实现

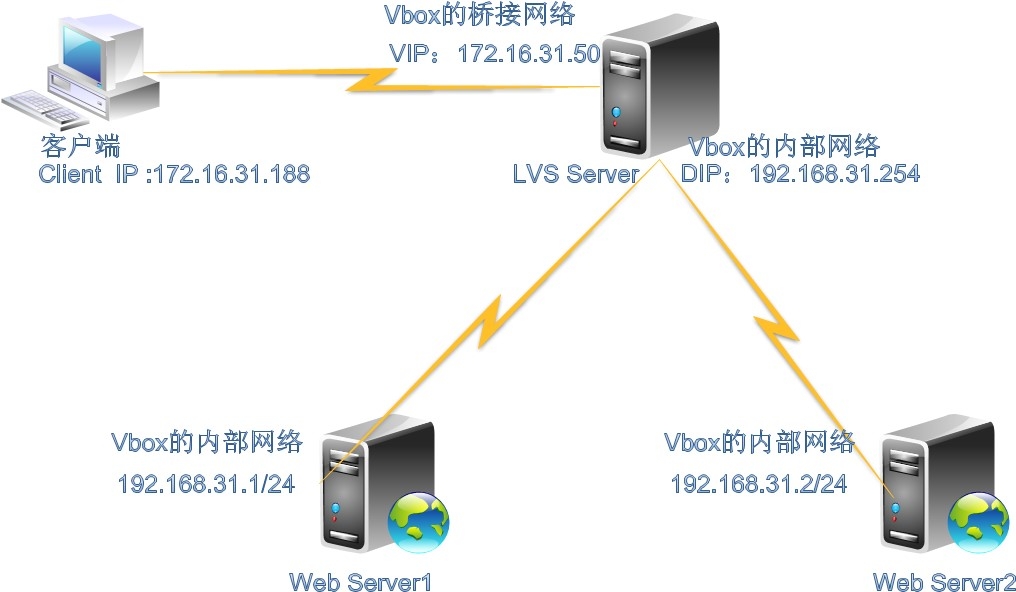

LVS-NAT架构图解:

一.名词解释:

DS:Director Server,前端的LVS Server

RS:Real Server;后端的WebServer

VIP:外网, 172.16.31.50

DIP:内网,192.168.31.254

RS1:RIP 192.168.31.1

RS2:RIP 192.168.31.2

前端是一个Director Server,有两个网卡,一个是公网(面向互联网);一个是连接各RS

外部网络是桥接网卡,内部网络是内部网络网卡连接的;

后端是Real Server,尽可能使用私有地址,网关应指向DIP,将RS做成web服务器

二.LVS-NAT模型实现负载均衡的工作方式,

NAT模型其实就是通过网络地址转换来实现负载均衡的,它的工作方式几乎跟DNAT一模一样的,目前的DNAT只能转发到一个目标地址,早期的DNAT是可以将请求转发到多个目标的,在LVS出现之后就将此功能从DNAT种去掉了,下面来说说NAT模型的工作方式或者说NAT模型是怎么实现负载均衡的,根据上图,

1.客户端请求VIP(也可以说是CIP请求VIP);

2.Director Server 收到用户的请求后,发现源地址为CIP请求的目标地址为VIP,那么DorectorServer会认为用户请求的是一个集群服务,那么Director Server 会根据此前设定好的调度算法将用户请求负载给某台Real Server ,假如说此时Director Server 根据调度算法的结果会将请求分摊到Real Server 1上去,那么Director Server 会将用户的请求报文中的目标地址,从原来的VIP改为Real Server 1的IP,然后再转发给Real Server 1;

3.此时Real Server 1收到一个源地址为CIP目标地址为自己的请求,那么Real Server1处理好请求后会将一个源地址为自己目标地址为CIP的数据包通过Director Server 发出去;

4.当Driector Server收到一个源地址为RealServer 1 的IP 目标地址为CIP的数据包,此时Driector Server 会将源地址修改为VIP,然后再将数据包发送给用户;

三.LVS用户空间工具ipvsadm的使用方法

其实LVS的本身跟iptables很相似,而且连命令的使用格式都很相似,其实LVS是根据iptables的框架开发的,那么LVS的本身分成了两个部分,第一部分是工作在内核空间的一个IPVS的模块,其实LVS的功能都是IPVS模块实现的;第二部分是工作在用户空间的一个用来定义集群服务的一个工具ipvsadm, 这个工具的主要作用是将管理员定义的集群服务列表传送给工作在内核空间中的IPVS模块,下面来简单的介绍下ipvsadm命令的用法

1.定义集群服务类的

#ipvsadm

-A 添加一个集群服务

-D 删除一个集群服务

-E 修改一个集群服务

-t VIP:端口 定义集群服务的类型为TCP的某个端口

-u VIP:端口 定义集群服务的类型为UDP的某个端口

-f 防火墙标记 定义集群服务的类型为防火墙标记

-s 调度算法 指定集群服务的调度算法

2.定义集群节点类的

#ipvsadm

-a 添加一个节点到集群服务

-d 从集群服务中删除一个节点

-e 修改集群服务器中的节点

-r 节点IP:端口 定义节点的IP及类型

-m 定义为NAT模型

-g 定义为DR模型

-i 定义为TUN模型

-w 权重 定义服务器的权重

-p --persistent [timeout] 持久稳固的服务。这个选项的意思是来自同一个客

户的多次请求,将被同一台真实的服务器处理。timeout 的默认值为300 秒。

3.其他

#ipvsadm

-L 查看

-n --numeric 输出IP 地址和端口的数字形式

-c --connection 显示LVS 目前的连接 如:ipvsadm -L -c

--stats 显示统计信息

-C 清空所有规则

-S 保存规则

-R 恢复规则

四.配置IP地址:

1.LVS Server的IP配置:

VIP:

[root@LVS network-scripts]# cat ifcfg-eth0 DEVICE="eth0" BOOTPROTO="static" HWADDR="08:00:27:85:86:F7" NM_CONTROLLED="yes" ONBOOT="yes" TYPE="Ethernet" IPADDR=172.16.31.50 NETMASK=255.255.0.0 GATEWAY=172.16.0.1

DIP:

[root@LVS network-scripts]# cat ifcfg-eth1 DEVICE="eth1" BOOTPROTO="static" HWADDR="08:00:27:3F:47:E1" NM_CONTROLLED="yes" ONBOOT="yes" TYPE="Ethernet" IPADDR=192.168.31.254 NETMASK=255.255.255.0 GATEWAY=172.16.0.1

2.Web Server服务器IP配置

Node1的web服务器IP设置:

[root@node1 network-scripts]# cat ifcfg-eth0 DEVICE="eth0" BOOTPROTO="static" HWADDR="08:00:27:23:2F:87" NM_CONTROLLED="yes" ONBOOT="yes" TYPE="Ethernet" IPADDR=192.168.31.1 NETMASK=255.255.0.0 GATEWAY=172.16.0.1

Node2的web服务器IP设置:

[root@node2 network-scripts]# cat ifcfg-eth0 DEVICE="eth0" BOOTPROTO="static" HWADDR="08:00:27:E0:A1:67" NM_CONTROLLED="yes" ONBOOT="yes" TYPE="Ethernet" IPADDR=192.168.31.2 NETMASK=255.255.255.0 GATEWAY=172.16.0.1

五.配置LVS Server启用转发功能

[root@LVS ~]# vim /etc/sysctl.conf net.ipv4.ip_forward = 1

[root@LVS ~]# sysctl -p net.ipv4.ip_forward = 1 net.ipv4.conf.default.rp_filter = 1 net.ipv4.conf.default.accept_source_route =0 kernel.sysrq = 0 kernel.core_uses_pid = 1 net.ipv4.tcp_syncookies = 1 error: "net.bridge.bridge-nf-call-ip6tables"is an unknown key error:"net.bridge.bridge-nf-call-iptables" is an unknown key error:"net.bridge.bridge-nf-call-arptables" is an unknown key kernel.msgmnb = 65536 kernel.msgmax = 65536 kernel.shmmax = 68719476736 kernel.shmall = 4294967296

服务器之间的时间尽量一致

六.启动默认http服务器

Node1和Node2:

[root@node1 ~]# service httpd start

Starting httpd: [ OK ]

[root@node2 ~]# service httpd start

Starting httpd: [ OK ]

设置好测试网页:

[root@node1 ~]# echo "node1.stu31.com"> /var/www/html/index.html

[root@node2 ~]# echo"node2.stu31.com" > /var/www/html/index.html

七.启用LVS-NAT模式的负载均衡

1.采用RR调度方法:

[root@LVS ~]# ipvsadm -A -t 172.16.31.50:80-s rr [root@LVS ~]# ipvsadm -a -t 172.16.31.50:80-r 192.168.31.1 -m [root@LVS ~]# ipvsadm -a -t 172.16.31.50:80-r 192.168.31.2 –m

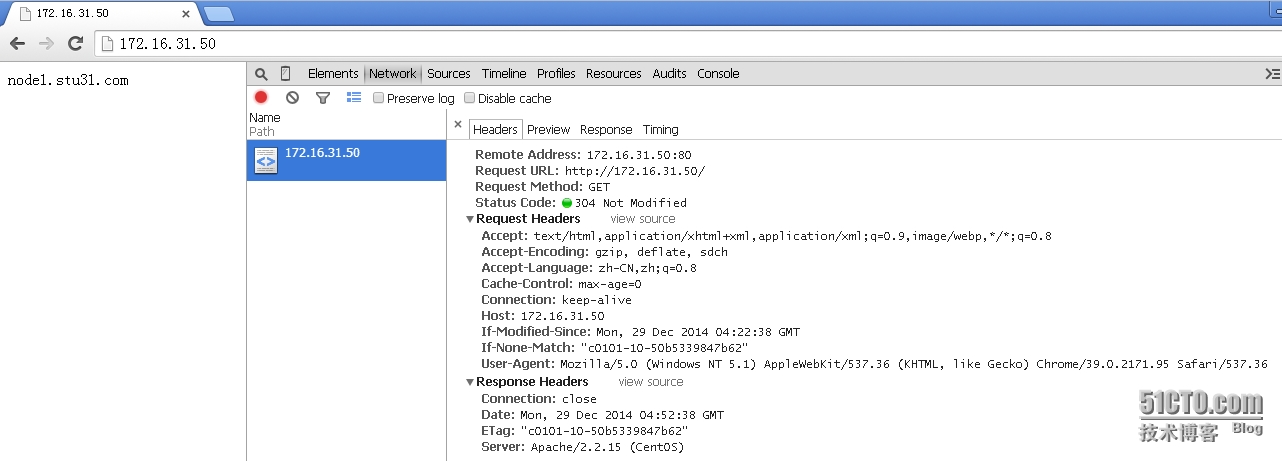

2.浏览器测试:

多刷新几次可以观察出可以轮流查询的!

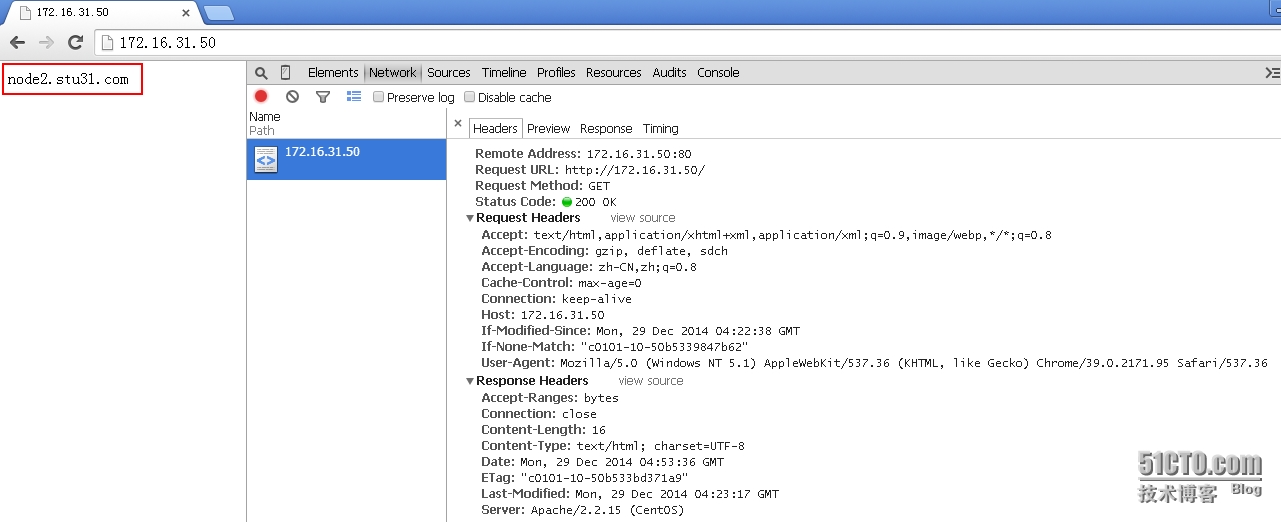

3.采用WRR加权调度算法:

[root@LVS ~]# ipvsadm -E -t 172.16.31.50:80-s wrr [root@LVS ~]# ipvsadm -e -t 172.16.31.50:80-r 192.168.31.2 -m -w 2

浏览器测试:

可以看出前两次查询都是node2服务器返回的结果

[root@LVS ~]# ipvsadm -L -n IP Virtual Server version 1.2.1 (size=4096) Prot LocalAddress:Port Scheduler Flags -> RemoteAddress:Port Forward Weight ActiveConn InActConn TCP 172.16.31.50:80 wrr -> 192.168.31.1:80 Masq 1 0 1 -> 192.168.31.2:80 Masq 2 0 3

我们将其中一台web服务器关闭

[root@node1 ~]# service httpd stop Stopping httpd: [ OK ]

浏览器刷新测试:

[root@LVS ~]# ipvsadm -L -n IP Virtual Server version 1.2.1 (size=4096) Prot LocalAddress:Port Scheduler Flags -> RemoteAddress:Port Forward Weight ActiveConn InActConn TCP 172.16.31.50:80 wrr -> 192.168.31.1:80 Masq 1 0 2 -> 192.168.31.2:80 Masq 2 0 9

由此可以知道LVS Server无法监控后端服务器的健康状态。

本文出自 “龙之守护” 博客,请务必保留此出处http://sohudrgon.blog.51cto.com/3088108/1598110

LVS-NAT模式负载均衡的实现