首页 > 代码库 > hadoop2.5.1伪分布式部署

hadoop2.5.1伪分布式部署

可参阅官方文档

http://hadoop.apache.org/docs/current/hadoop-project-dist/hadoop-common/SingleCluster.html

文件下载:

http://mirrors.hust.edu.cn/apache/hadoop/common/

注:可直接使用2.5.2或2.6.0版本 都解决了2.5.1中不稳定bug

1 伪分布式部署

以测试通过的为例

Linux version 2.6.32-431.el6.x86_64 Red Hat 4.4.7-4

Jdk java version "1.7.0_67"

Hadoop 2.5.1

1.1 环境准备(有些只是参考,环境配置不好就没办法进行部署安装):

1、java -version

检查cat /etc/profile

export JAVA_HOME=/usr/bin/jdk1.7.0_67

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:${JRE_HOME}/bin:$PATH

没有追加上即可 source /etc/profile执行实时生效

2、如果是普通用户,注意权限

vim /etc/sudoers

grid ALL=(ALL) ALL

如果无法编辑进行如下操作

a、授权 chmod u+w /etc/sudoers

b、编辑 vi /etc/sudoers

c、取消权限 chmod u-w /etc/sudoers

1.2 部署安装

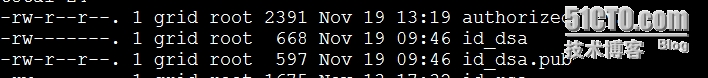

ssh-keygen -t dsa -P ‘‘ -f ~/.ssh/id_dsa

cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys

在cd /home/grid/.ssh路径下

测试:ssh localhost

配置hadoop

进入../hadoop-2.5.1/etc/hadoop目录下,针对以下文件进行操作

httpfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>4</value>

</property>

</configuration>

core-site.xml

<configuration>

<property>

<name>fs.default.name</name>

<value>hdfs://192.168.3.170:9000</value>

</property>

</configuration>

里边是没有直接的mapred-site.xml文件,要把mapred-site.xml.template复制成mapred-site.xml再进行修改

mapred-site.xml

<configuration>

<property>

<name>mapred.job.tracker</name>

<value>hdfs://192.168.3.170:9001</value>

</property>

</configuration>

环境变量配置hadoop-env.sh

export JAVA_HOME=/usr/bin/jdk1.7.0_67

export HADOOP_PREFIX=/home/grid/hadoop-2.5.1

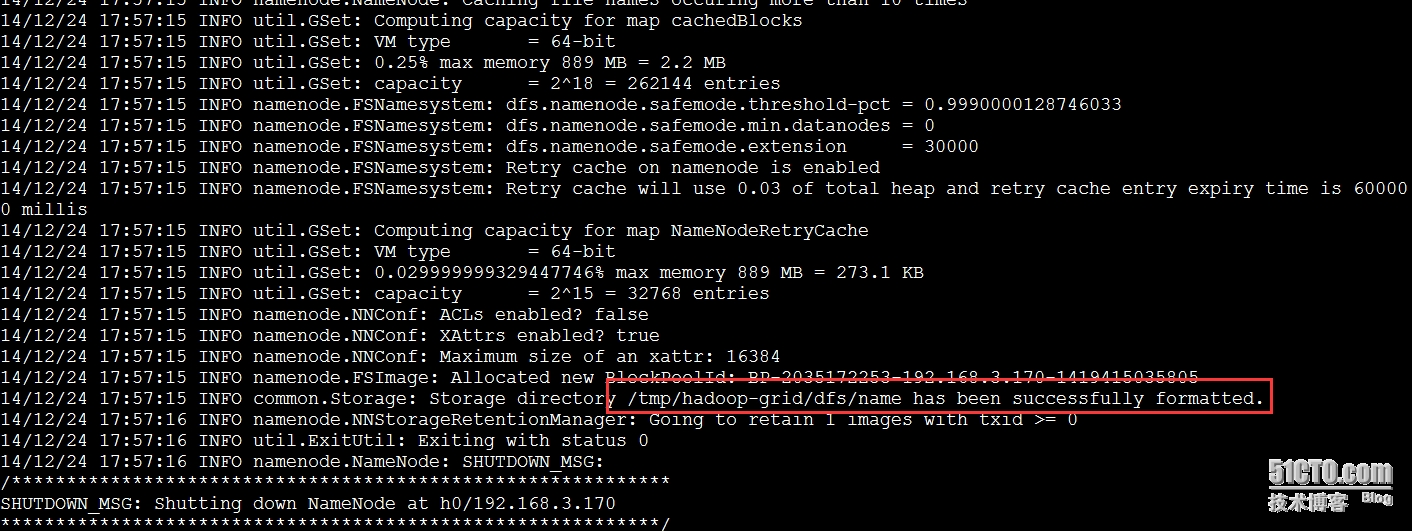

格式化

bin/hdfs namenode –format

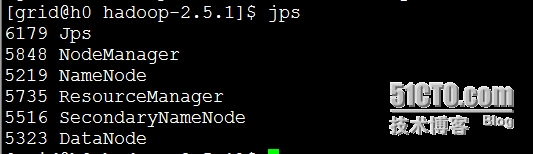

完成时候启动

sbin/start-dfs.sh(此时可以查看50070和9000端口是否启动,启动可成功)

sbin/start-yarn.sh

测试

首先查看jps

有了这些节点再进行下面步骤

1、查看端口是否启动

netstat -ano | grep 50070

netstat -ano | grep 8088

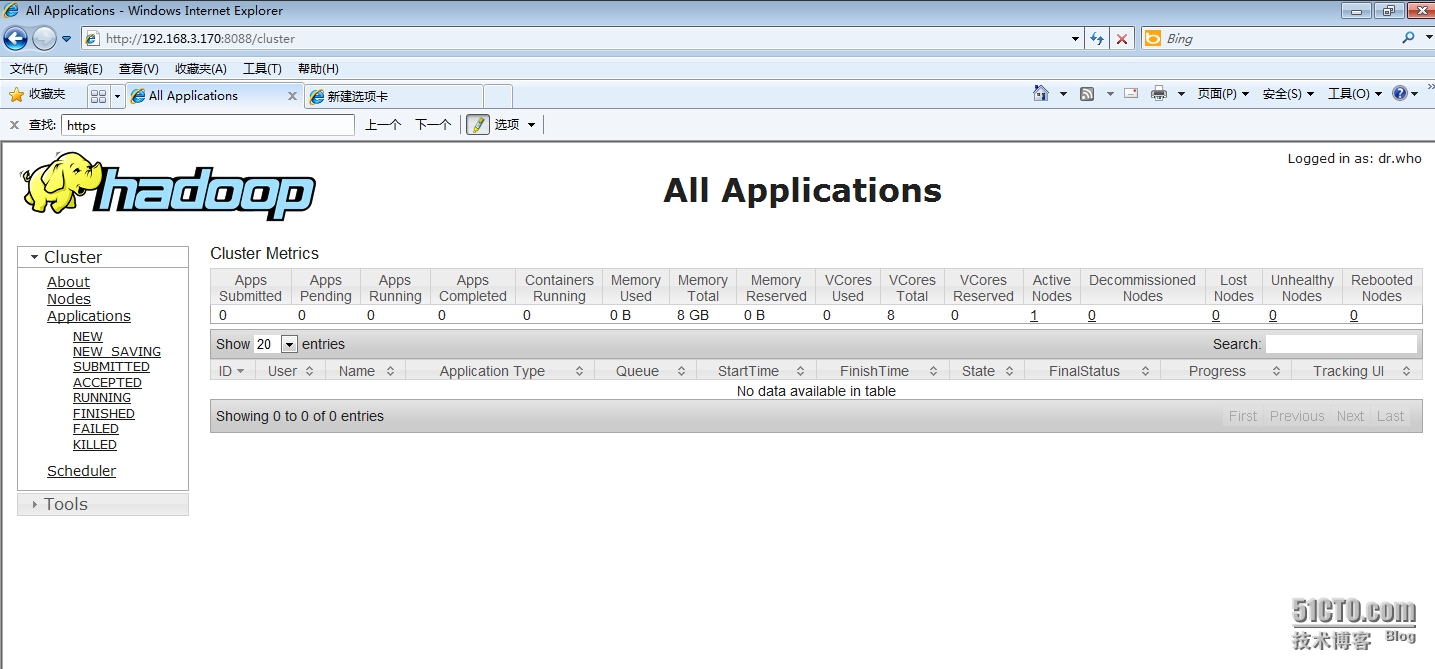

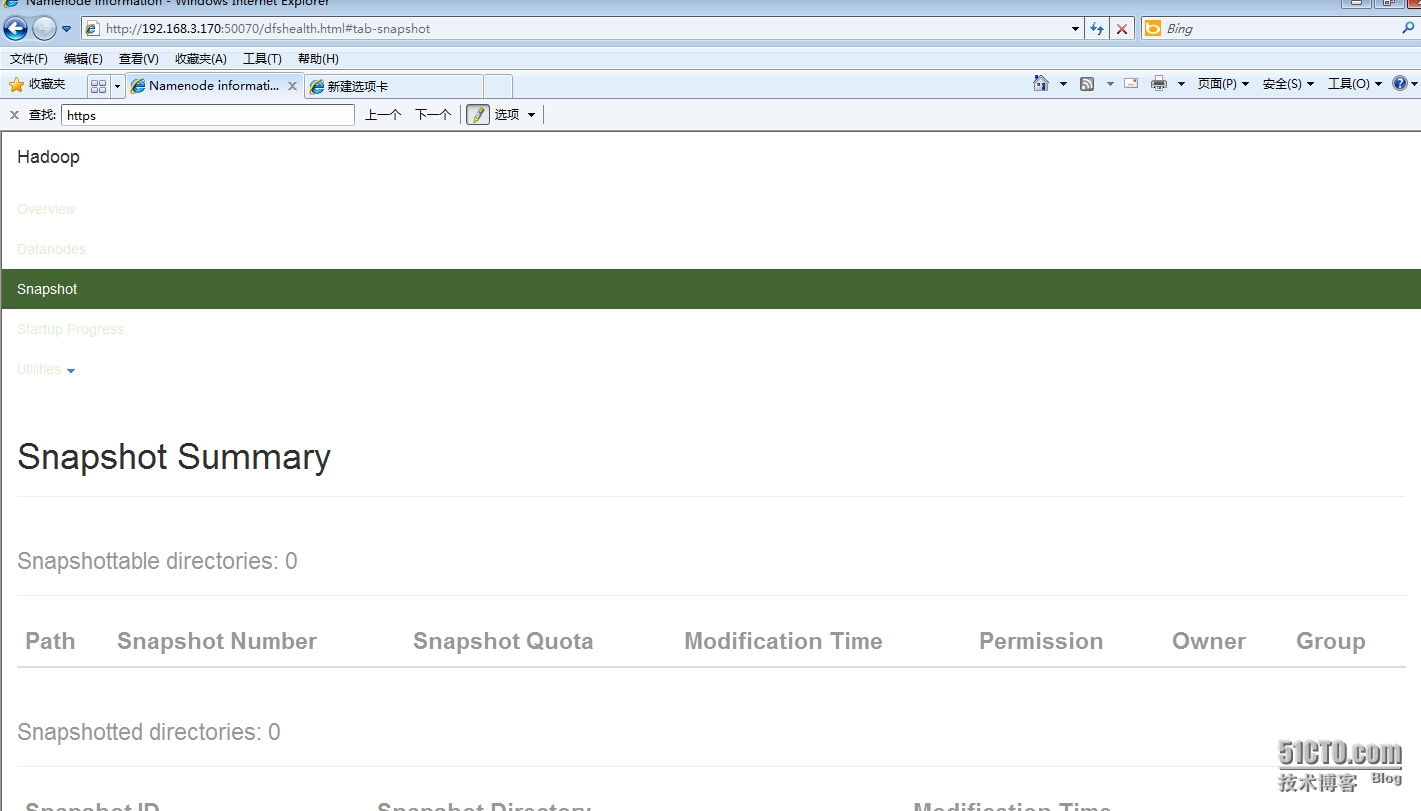

2、页面访问

http://192.168.3.170: 8088

http://192.168.3.170: 50070/

3、数据测试

a、写入数据

bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.5.1.jar grep input output ‘dfs[a-z.]+‘

b、读取数据

bin/hdfs dfs -get output output

hadoop2.5.1伪分布式部署