首页 > 代码库 > 【Spark亚太研究院系列丛书】Spark实战高手之路-第一章 构建Spark集群(第五步)(6)

【Spark亚太研究院系列丛书】Spark实战高手之路-第一章 构建Spark集群(第五步)(6)

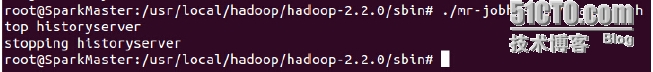

结束historyserver的命令如下所示:

第四步:验证Hadoop分布式集群

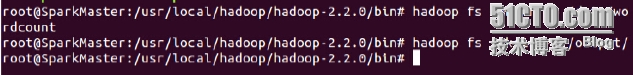

首先在hdfs文件系统上创建两个目录,创建过程如下所示:

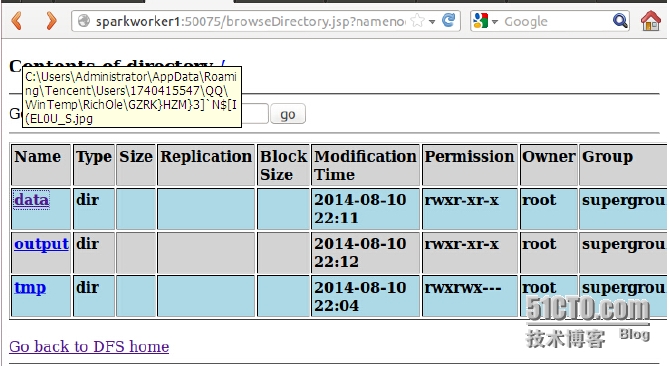

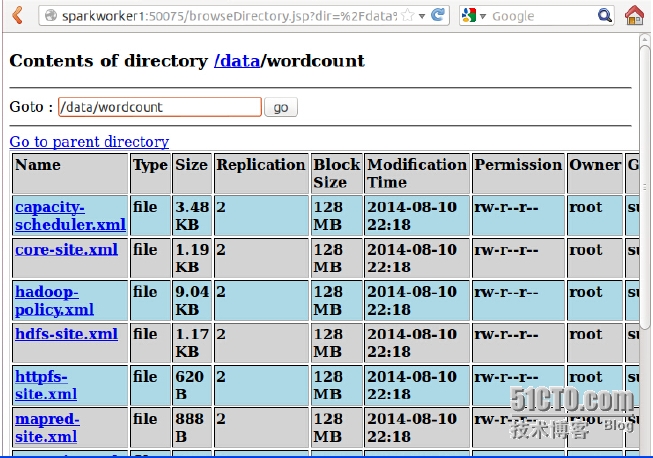

Hdfs中的/data/wordcount用来存放Hadoop自带的WordCount例子的数据文件,程序运行的结果输出到/output/wordcount目录中,透过Web控制可以发现我们成功创建了两个文件夹:

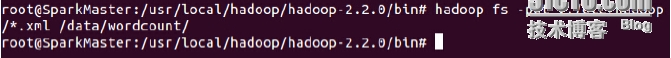

接下来将本地文件的数据上传到HDFS文件夹中:

透过Web控制可以发现我们成功上传了文件:

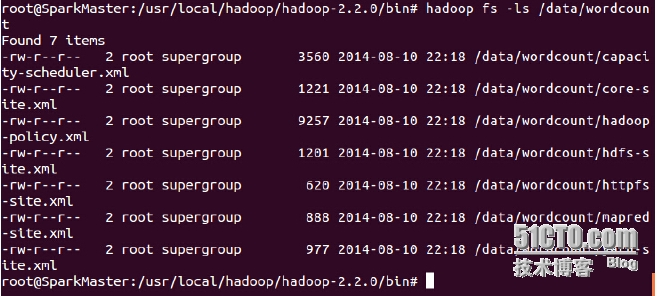

也可通过hadoop的hdfs命令在控制命令终端查看信息:

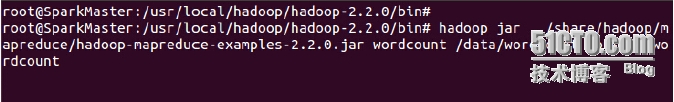

运行Hadoop自带的WordCount例子,执行如下命令:

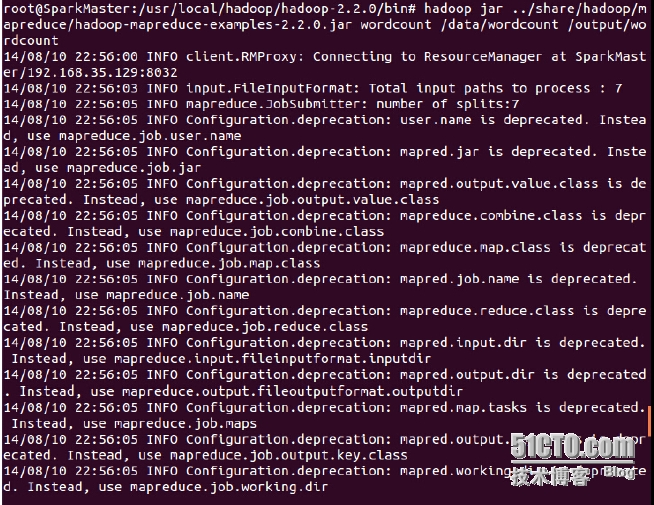

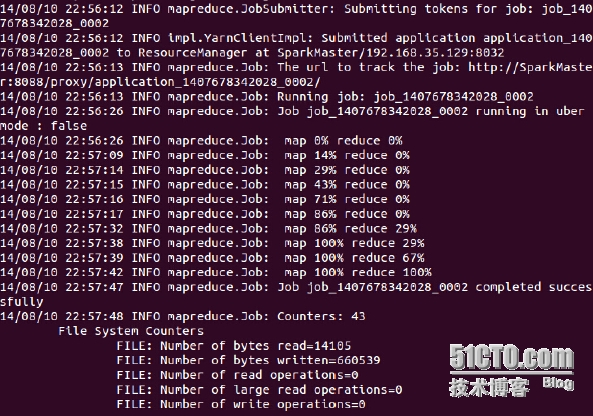

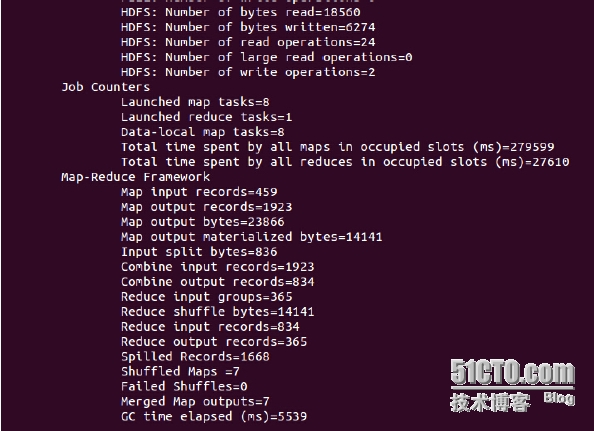

运行过程如下:

本文出自 “Spark亚太研究院” 博客,请务必保留此出处http://rockyspark.blog.51cto.com/2229525/1571250

【Spark亚太研究院系列丛书】Spark实战高手之路-第一章 构建Spark集群(第五步)(6)

声明:以上内容来自用户投稿及互联网公开渠道收集整理发布,本网站不拥有所有权,未作人工编辑处理,也不承担相关法律责任,若内容有误或涉及侵权可进行投诉: 投诉/举报 工作人员会在5个工作日内联系你,一经查实,本站将立刻删除涉嫌侵权内容。