首页 > 代码库 > close_wait状态的产生原因及解决(转)

close_wait状态的产生原因及解决(转)

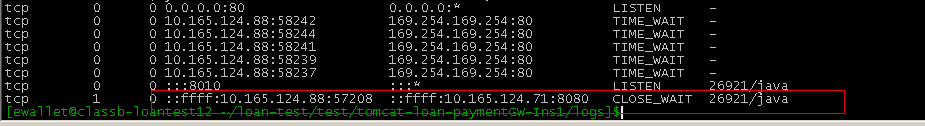

最近测试环境server由于需要与大量的后台server交互,今天突然发现有大量的close_wait产生,于是仔细研究了一下:

如果我们的服务器程序处于CLOSE_WAIT状态的话,说明套接字是被动关闭的!

因为如果是CLIENT端主动断掉当前连接的话,那么双方关闭这个TCP连接共需要四个packet:

1.Client -> FIN -> Server

2.Client <- ACK <- Server 这时候Client端处于FIN_WAIT_2状态;而Server 程序处于CLOSE_WAIT状态。

3.Client <- FIN <- Server 这时Server 发送FIN给Client,Server 就置为LAST_ACK状态。

4.Client -> ACK -> Server Client回应了ACK,那么Server 的套接字才会真正置为CLOSED状态。

Server 程序处于CLOSE_WAIT状态,而不是LAST_ACK状态,说明还没有发FIN给Client,那么可能是在关闭连接之前还有许多数据要发送或者其他事要做,

导致没有发这个FIN packet。

通常来说,一个CLOSE_WAIT会维持至少2个小时的时间(这个时间外网服务器通常会做调整,要不然太危险了)。

如果有个流氓特地写了个程序,给你造成一堆的CLOSE_WAIT,消耗你的资源,那么通常是等不到释放那一刻,系统就已经解决崩溃了。

只能通过修改一下TCP/IP的参数,来缩短这个时间:修改tcp_keepalive_*系列参数有助于解决这个问题。

但是实际上,还是主要是因为我们的程序代码有问题,通常是如下问题:

比如被动关闭的是客户端。。。

当对方调用closesocket的时候,你的程序正在

C代码

int nRet = recv(s,....);

if (nRet == SOCKET_ERROR)

{

// closesocket(s);

return FALSE;

}

很多人就是忘记了那句closesocket,这种代码太常见了。

我的理解,当主动关闭的一方发送FIN到被动关闭这边后,被动关闭这边的 TCP马上回应一个ACK过去,同时向上面应用程序提交一个ERROR,

导致上面的SOCKET的send或者recv返回SOCKET_ERROR,正常情况下,如果上面在返回SOCKET_ERROR后调用了 closesocket,那么被动关闭的者一方的TCP就会发送一个FIN过去,自己的状态就变迁到LAST_ACK.

close_wait

TCP状态变迁

转自:https://my.oschina.net/gehui/blog/494898

CLOSE_WAIT状态的生成原因

首先我们知道,如果我们的Client程序处于CLOSE_WAIT状态的话,说明套接字是被动关闭的!

因为如果是Server端主动断掉当前连接的话,那么双方关闭这个TCP连接共需要四个packet:

Server ---> FIN ---> Client

Server <--- ACK <--- Client

这时候Server端处于FIN_WAIT_2状态;而我们的程序处于CLOSE_WAIT状态。

Server <--- FIN <--- Client

这时Client发送FIN给Server,Client就置为LAST_ACK状态。

Server ---> ACK ---> Client

Server回应了ACK,那么Client的套接字才会真正置为CLOSED状态。

我们的程序处于CLOSE_WAIT状态,而不是LAST_ACK状态,说明还没有发FIN给Server,那么可能是在关闭连接之前还有许多数据要发送或者其他事要做,导致没有发这个FIN packet。

原因知道了,那么为什么不发FIN包呢,难道会在关闭己方连接前有那么多事情要做吗?

elssann举例说,当对方调用closesocket的时候,我的程序正在调用recv中,这时候有可能对方发送的FIN包我没有收到,而是由TCP代回了一个ACK包,所以我这边套接字进入CLOSE_WAIT状态。

所以他建议在这里判断recv函数的返回值是否已出错,是的话就主动closesocket,这样防止没有接收到FIN包。

因为前面我们已经设置了recv超时时间为30秒,那么如果真的是超时了,这里收到的错误应该是WSAETIMEDOUT,这种情况下也可以主动关闭连接的。

还有一个问题,为什么有数千个连接都处于这个状态呢?难道那段时间内,服务器端总是主动拆除我们的连接吗?

不管怎么样,我们必须防止类似情况再度发生!

首先,我们要保证原来的端口可以被重用,这可以通过设置SO_REUSEADDR套接字选项做到:

重用本地地址和端口

以前我总是一个端口不行,就换一个新的使用,所以导致让数千个端口进入CLOSE_WAIT状态。如果下次还发生这种尴尬状况,我希望加一个限定,只是当前这个端口处于CLOSE_WAIT状态!

在调用

sockConnected = socket(AF_INET, SOCK_STREAM, 0);

之后,我们要设置该套接字的选项来重用:

1 /// 允许重用本地地址和端口: 2 3 /// 这样的好处是,即使socket断了,调用前面的socket函数也不会占用另一个,而是始终就是一个端口 4 5 /// 这样防止socket始终连接不上,那么按照原来的做法,会不断地换端口。 6 7 int nREUSEADDR = 1; 8 9 setsockopt(sockConnected, 10 11 SOL_SOCKET, 12 13 SO_REUSEADDR, 14 15 (const char*)&nREUSEADDR, 16 17 sizeof(int));

教科书上是这么说的:这样,假如服务器关闭或者退出,造成本地地址和端口都处于TIME_WAIT状态,那么SO_REUSEADDR就显得非常有用。

也许我们无法避免被冻结在CLOSE_WAIT状态永远不出现,但起码可以保证不会占用新的端口。

其次,我们要设置SO_LINGER套接字选项:

从容关闭还是强行关闭?

LINGER是“拖延”的意思。

默认情况下(Win2k),SO_DONTLINGER套接字选项的是1;SO_LINGER选项是,linger为{l_onoff:0,l_linger:0}。

如果在发送数据的过程中(send()没有完成,还有数据没发送)而调用了closesocket(),以前我们一般采取的措施是“从容关闭”:

因为在退出服务或者每次重新建立socket之前,我都会先调用

1 /// 先将双向的通讯关闭 2 3 shutdown(sockConnected, SD_BOTH); 4 5 /// 安全起见,每次建立Socket连接前,先把这个旧连接关闭 6 7 closesocket(sockConnected);

我们这次要这么做:

设置SO_LINGER为零(亦即linger结构中的l_onoff域设为非零,但l_linger为0),便不用担心closesocket调用进入“锁定”状态(等待完成),不论是否有排队数据未发送或未被确认。这种关闭方式称为“强行关闭”,因为套接字的虚电路立即被复位,尚未发出的所有数据都会丢失。在远端的recv()调用都会失败,并返回WSAECONNRESET错误。

在connect成功建立连接之后设置该选项:

1 linger m_sLinger; 2 3 m_sLinger.l_onoff = 1; // (在closesocket()调用,但是还有数据没发送完毕的时候容许逗留) 4 5 m_sLinger.l_linger = 0; // (容许逗留的时间为0秒) 6 7 setsockopt(sockConnected, 8 9 SOL_SOCKET, 10 11 SO_LINGER, 12 13 (const char*)&m_sLinger, 14 15 sizeof(linger));

另外:

通常来说,一个CLOSE_WAIT会维持至少2个小时的时间。如果有个流氓特地写了个程序,给你造成一堆的CLOSE_WAIT,消耗

你的资源,那么通常是等不到释放那一刻,系统就已经解决崩溃了。

只能通过修改一下TCP/IP的参数,来缩短这个时间:修改tcp_keepalive_*系列参数有助于解决这个问题。tcp_keepalive_time :INTEGER

默认值是7200(2小时)当keepalive打开的情况下,TCP发送keepalive消息的频率。(由于目前网络攻击等因素,造成了利用这个进行的攻击很频繁,曾经也有cu的朋友提到过,说如果2边建立了连接,然后不发送任何数据或者rst/fin消息,那么持续的时间是不是就是2小时,空连接攻击? tcp_keepalive_time就是预防此情形的.我个人在做nat服务的时候的修改值为1800秒)

总结

也许我们避免不了CLOSE_WAIT状态冻结的再次出现,但我们会使影响降到最小,希望那个重用套接字选项能够使得下一次重新建立连接时可以把CLOSE_WAIT状态踢掉。

close_wait状态的产生原因及解决(转)