首页 > 代码库 > Hadoop初学指南(5)--MapReduce入门

Hadoop初学指南(5)--MapReduce入门

本文将介绍Hadoop中的重点MapReduce的入门知识。

(1)MapReduce概述

MapReduce是一种分布式计算模型,由Google提出,主要用于搜索领域,解决海量数据的计算问题。

MR由两个阶段组成:Map和Reduce,在Hadoop中用户只需要实现map()和reduce()两个函数,即可实现分布式计算,非常简单。这两个函数的形参是key、value对,表示函数的输入信息。

(2)MR执行流程

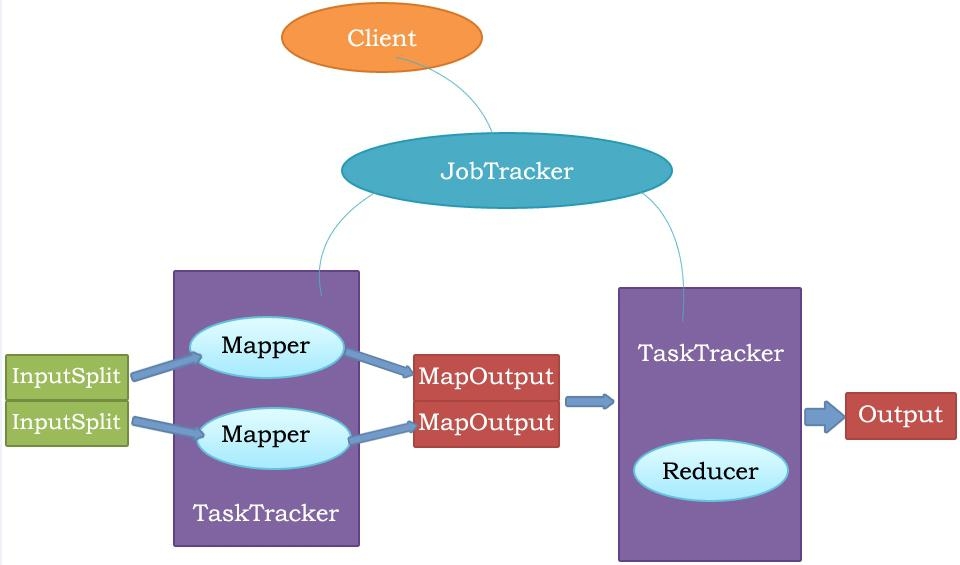

客户端的代码会提交给JobTracker,也就是JobTracker接受由用户提交的计算任务,然后由JobTracker分配给TaskTracker来执行。在TaskTracker中,有的是执行Mapper任务,有的是执行Reducer任务。Map接受的是输入数据,Reduce接受的输入数据是Map的输出数据,而Reduce的输出数据就是整个任务的输出数据。Map和Reduce可能有多个,每一个Map或者Reduce对应一个java进程。如下图所示:

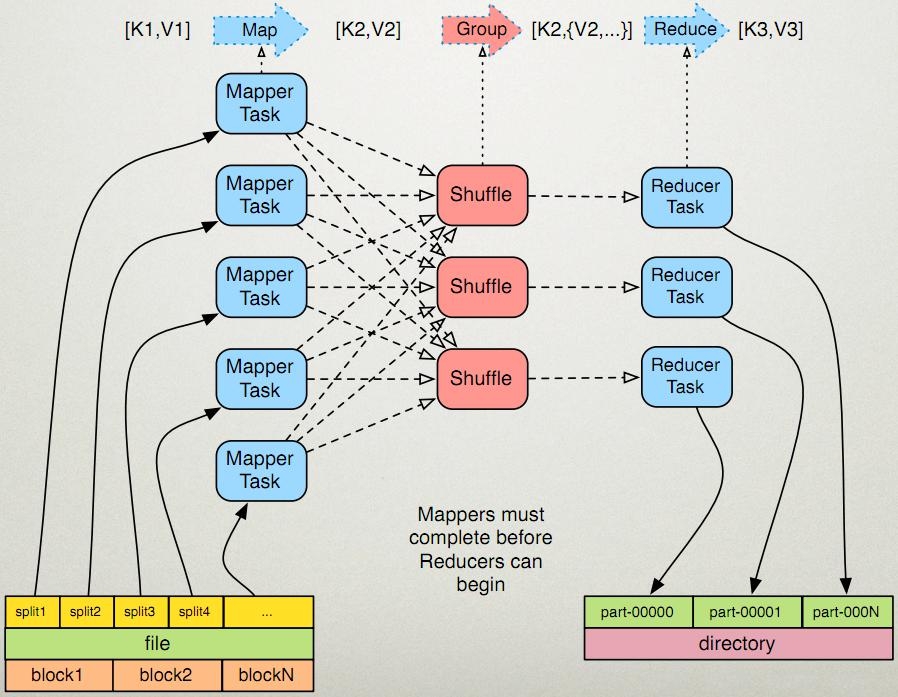

如下图所示,输入文件会送给5个mapper任务来执行,每个mapper任务拿到的是不同的数据,每个mapper都会分散到不同的shuffle,shuffle又会送给reducer。由此可见map任务输出的任务数量与reduce任务的数量是相同的。

(3)MR的详细执行步骤

①map任务处理

1.1 读取输入文件内容,解析成key、value对。对输入文件的每一行,解析成key、value对。每一个键值对调用一次map函数。

1.2 写自己的逻辑,对输入的key、value处理,转换成新的key、value输出。

1.3 对输出的key、value进行分区。

1.4 对不同分区的数据,按照key进行排序、分组。相同key的value放到一个集合中。

1.5 (可选)分组后的数据进行归约。

②reduce任务处理

2.1 对多个map任务的输出,按照不同的分区,通过网络copy到不同的reduce节点。

2.2 对多个map任务的输出进行合并、排序。写reduce函数自己的逻辑,对输入的key、value处理,转换成新的key、value输出。

2.3 把reduce的输出保存到文件中。

用相对直白的形式来说:

1.1读取hdfs中的文件。每一行解析成一个<k,v>。每一个键值对调用一次map函数

1.2 覆盖map(),接收1.1产生的<k,v>,进行处理,转换为新的<k,v>输出

1.3 对1.2输出的<k,v>进行分区。默认分为1个区。

1.4 对不同分区中的数据进行排序(按照k)、分组。分组指的是相同key的value放到一个集合中。

1.5 (可选)对分组后的数据进行规约。

2.1 多个map任务的输出,按照不同的分区,通过网络copy到不同的reduce节点上。

2.2 对多个map的输出进行合并、排序。覆盖reduce函数,接收的是分组后的数据,实现自己的业务逻辑,处理后,产生新的<k,v>输出。

2.3 对reduce输出的<k,v>写到hdfs中。

本文出自 “Xlows” 博客,转载请与作者联系!